图神经网络(Graph Neural Networks, GNNs)在生物医药、知识图谱和AI4S等关键领域展现出巨大潜力,随着真实应用场景中图规模迅速扩展至亿级边甚至更高,GNN训练面临通信开销与计算瓶颈等相关问题。

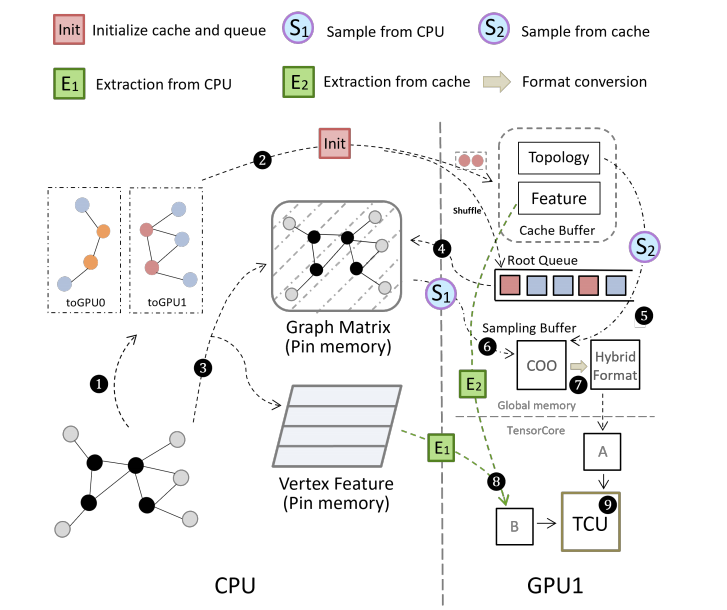

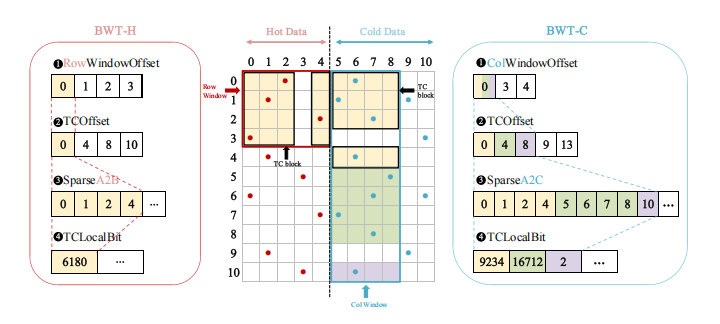

近日,我中心人工智能部研发了TAC框架,系统性地融合了数据亲和缓存填充算法(Affinity-aware Caching Initialization Algorithm,ACI)、稀疏性感知的混合矩阵存储格式(HybridMatrix)以及多层次细粒度训练流水线三大关键技术。TAC 通过提升缓存局部性有效降低全局通信开销,并借助 Tensor Core 高效加速稀疏矩阵计算。实验证明端到端性能相比其他框架显著提升。

该研究成果已被第31届ACM SIGPLAN编程语言与并行实践原理年会(PPoPP 2026)录用。PPoPP是CCF推荐A类会议,也是高性能计算与系统领域的顶级学术会议。本工作得到国家重点研发计划、中国科学院先导专项的支持。论文第一作者为我中心工程师梁智强,通讯作者为王珏正高级工程师和王彦棡研究员,博士研究生高宏宇为共同第一作者。

TAC 框架系统架构图

混合稀疏矩阵格式

相关成果:

[1] Zhiqiang Liang,Hongyu Gao,Jue Wang,Fang Liu,Xingguo Shi,Junyu Gu,Peng Di,San Li,Lei Tang,Chunbao Zhou,Lian Zhao,Yangang Wang,Xuebin Chi. TAC: Cache-based System for Accelerating Billion-Scale GNN Training on Multi-GPU Platform. ACM SIGPLAN Symposium on Principles & Practice of Parallel Programming(PPoPP’26).

责任编辑:郎杨琴